Установка jetson-containers

Будем устанавливать jetson-containers в папку /srv.

Установка прав на папку

sudo chown :andrey /srv

sudo chmod g+w /srv

Скачаем jetson-containers из репозитория и установим

cd /srv

git clone https://github.com/dusty-nv/jetson-containers

bash jetson-containers/install.sh

Включим использование докером GPU при создании контейнеров

Для этого отредактируем /etc/docker/daemon.json, добавив строку “default-runtime”: “nvidia”:

sudo nano /etc/docker/daemon.json

---

{

"runtimes": {

"nvidia": {

"args": [],

"path": "nvidia-container-runtime"

}

},

"default-runtime": "nvidia"

}

---

Перезапустим докер

sudo systemctl restart docker

sudo docker info | grep 'Default Runtime'

---

Default Runtime: nvidia

Добавим себя в группу docker

sudo usermod -aG docker $USER

Установим контейнер text-generation-webui

cd /srv

sudo docker run --runtime nvidia -it --rm --network=host dustynv/text-generation-webui:main-r36.2.0

docker images

docker rmi <IMAGE ID>

Откроем интерфейс text-generation-webui

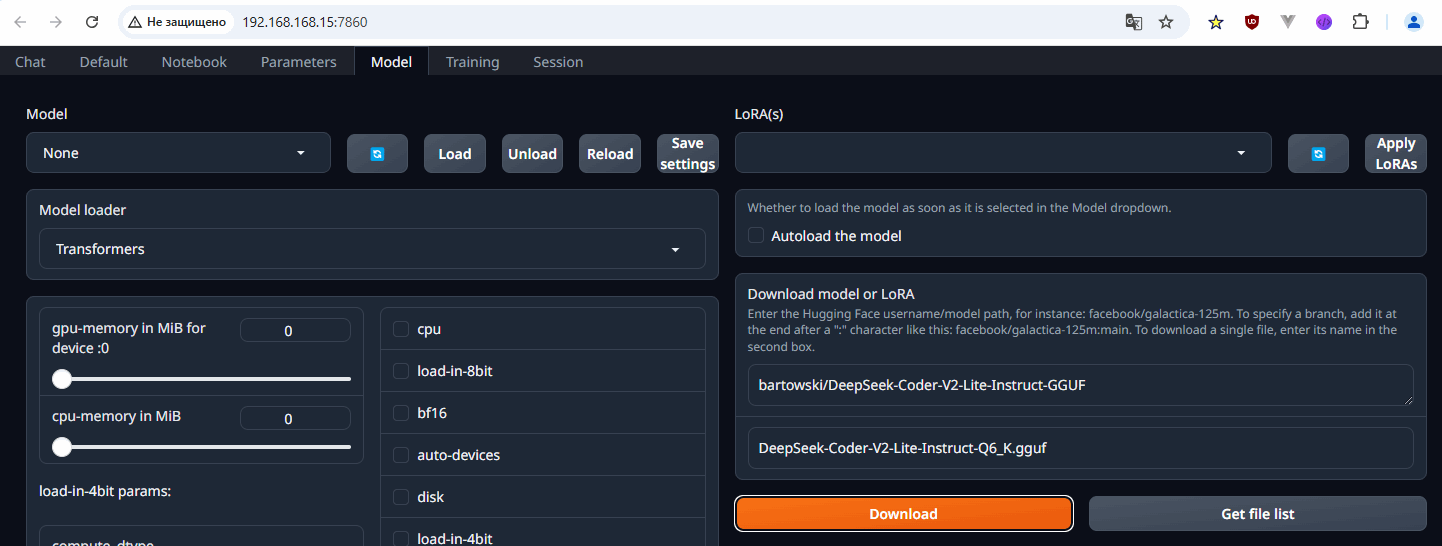

IP-адрес нашего модуля 192.168.168.15 В браузере вводим: http://192.168.168.15:7860

Загрузка моделей LLM

Для пробы используем модель для программирования https://huggingface.co/bartowski/DeepSeek-Coder-V2-Lite-Instruct-GGUF.

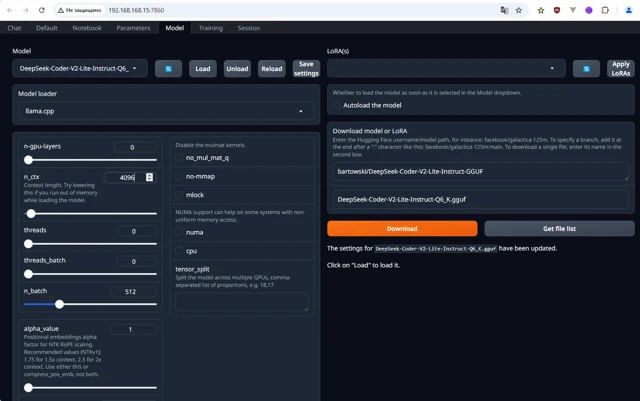

В интерфейсе заходим на вкладу Model и в секции Download model or LoRA в верхнее поле вставляем часть адреса модели: bartowski/DeepSeek-Coder-V2-Lite-Instruct-GGUF (автор/имя модели).

Нажимаем кнопку Get File list и увидим все доступные варианты этой модели.

В процессе загрузки видим:

Downloading the model to /data/models/text-generation-webui

После окончания загрузки нажимаем кнопку (1) для обновления списка доступных моделей (2), выбираем в списке загруженную модель и нажимаем кнопку Load (3).

И видим ошибку загрузки модели.

Я пробовал 3 раза переустановить text-generation-webui и разные модели (4K-5K-6K), запустить хоть одну модель не удалось.

Возможно, по тому, что докер образ text-generation-webui создан больше года назад и за это время появились несовместимости между его компонентами и современными LLM.

Примеры ошибок:

unknown model architecture: 'qwen3', Failed to load the model

error loading model: unknown model architecture: 'deepseek2', llama_load_model_from_file: failed to load model

error loading model: done_getting_tensors: wrong number of tensors; expected 292, got 291

Вероятно, лучше не использовать docker образ, а установить text-generation-webui вручную. Возможно, попробую потом.